的范式转变——达沃斯论坛杨立昆对线人工智能从大语言模型向物理人工智能

要接近真正的智能◇□•…◇★,需要下一代能理解现实世界的 AI 系统□★•:能处理高连续噪声数据=◁□★▽●、构建世界预测模型(预判环境演变和自身行为对环境的影响)•◁◁△、具备规划和核心推理能力■▪△,且可控▽◇■、安全的系统-•…△★★,这也是即将到来的物理人工智能革命的核心方向△▲。

问题 10•◇-◆■:展望 2035 年(未来 10-15 年)◆◆◆◇▪,AI 将如何改变经济△☆、机构…◁◆▷?AI 发展的成功与失败分别是什么样子□○★•=■?

AMI 的研究并非全新开始▪▼,而是我在 Meta 时就着手的 ☆▲“先进机器智能▪■” 项目的延续◆◇▷•,该项目采用自下而上的研究模式▪▽☆,由研究者主动参与而非自上而下的指令安排▼▼○●■。

过去十年推动 AI 发展的最大因素•□•▼●,并非某一项特定的技术突破(如Transformer)△=,而是AI 研究的开放性—— 研究者公开论文◁◆=★、开源代码=•◁▷…,让更多人参与其中●…,推动领域快速进步▲△。

关于 AI 与人类智慧的关系○▼=◇、转型成本和失业问题我暂时忘记了这一问题的具体答案•▽◆-☆,因时间有限暂未作答▼●★◆。

做好随时转换专业领域▽…、更换工作的准备◁●★•…△,核心是掌握 ■△★▽▷◇“如何学习▲□-□▲○”☆▼◆▷,而非单一的专业技能=▼●。闪电问答环节

问题 5•-◇□…▷:您创办的 Advanced Machine Intelligence(AMI)试图解决当前领先系统无法解决的什么问题■▼◇□○▷?开发出稳健世界模型的架构需要多久•◆?

当前领先的 AI 系统多依赖语言数据-★、基于生成式架构…■□◇▽,无法处理现实世界的传感器……▪、视频等连续数据▽□•,也无法构建有效的世界模型▷△;而 AMI 的核心目标●☆,是构建能从传感器数据○▪◁△▽、视频中学习的 AI 系统-△•,打造世界模型—— 学习世界在 t 时刻的状态◆△☆◇●,以及系统行动后 t+1 时刻的世界状态▲△▼★,进而通过规划行动完成任务▪☆=▷。

问题 9★☆:AI 会在哪些方面增强人类智慧而非取代◆■▼?社会低估了哪些转型成本▷•◁?是否在失业问题上存在错误提问◁○◆?对年轻教育工作者和职场领袖有何建议…★•◇▼?

AI 会成为人类的智能助理▲•■●△◆,嵌入智能眼镜等穿戴设备=▲•,随时协助人类工作△○,增强人类智力☆•、帮助人类做出更理性的决策▲●;而人类与超智能 AI 系统的关系◆=,会如同企业 / 政界领袖与更聪明的幕僚★◁…•、教授与更优秀的学生★-◆◁☆、研究者与更出色的同事一样…■▷▽•●,核心是人类掌控 AI○▷=,利用 AI 提升全球的智力总量□-▲■▷◇。

而当前的问题是□☆=▲=,越来越多的产业研究实验室从开放转向封闭(如谷歌•-▲•、Meta 的 Fair 实验室)○◇▪…,这会严重减缓 AI 发展☆☆■●,尤其是西方和美国-○=▷•-;反观中国的产业研究实验室更为开放▽▪▪▷□□,目前最好的开源模型均来自中国▲◆○…,已成为全球研究界的主流选择•…☆■▽。

其次◇•▼▽◇,AI 封闭化的核心风险在于☆○•●★:权力和数字信息的集中控制◆▲●▽▼◆。如果全球 AI 系统被少数美国或中国的专有公司掌控★•-▼•=,会严重威胁民主健康▪▼•△▼○、文化和语言多样性•○▼●▽、不同价值体系…▽•△-▷,这也是 AI 远比 ■=▼=•“统治世界▽…○◁” 更迫切的风险▼■。

当前对 AI 对齐的思考存在误区•□,多数人从 LLM 角度出发☆▷★,试图通过训练让 LLM 避免生成不当内容=●○☆▼-,但这种思路本身错误▽▷•,因为未来的 AI 架构将发生根本性变化■▽○,而非停留在 LLM 阶段●◆▼□☆。

对话主题■▽■▪★:人工智能从大语言模型向物理人工智能的范式转变▪○=▪、AGI 发展▲★◆、AI 研究开源•▷■●▷、AI 风险与未来发展等◇…■。

被低估且最紧迫的风险○▪■=-:AI 权力的集中控制(企业或政府垄断 AI)▪▪•…●,这会左右人类获取信息的途径▲•-☆,威胁民主和多样性■•▽★;其次是人类对 AI 系统的滥用-…◁☆▲=,但这并非 AI 独有的风险◁○▷▲,会有相应的应对措施◆…,无需过度担忧-○☆▷。

问题 6▪□:如果前沿 AI 变得封闭◆○▲■-、专有且地缘政治孤立=▲◇▲,存在哪些风险◆…◁○★★?开放性是竞争优势还是需要保护的公共产品◁▷▽■◆◁?开放的边界在哪里…▷■?

关于经济层面的风险(如就业流失)▼●▷☆:经济学界预测 AI 将使生产力每年提高约 6%◆★◆•○-,且不会造成大规模失业 —— 因为科技在经济中的传播速度◆◇▽,受限于人类学习使用科技的速度△◇,这是一种天然的 ■▪▲“监管机制…-▲-◇▷”▼★△•-。

被严重高估的风险-●=•●:AI 将统治世界▪▪▪••、带来世界末日的 ▽-“存在主义风险▲★◆”△□=▷■,这类说法纯粹是无稽之谈▼•☆★▷,还会分散领导者对真正紧迫问题的注意力■●■▼。

建立多元=☆、开放的 AI 治理体系•◆,避免 AI 权力集中•●,让 AI 的发展服务于全人类的利益◆▽◇•,而非少数主体△=。返回搜狐…•◇…••,查看更多

希望世界领导者理解的核心理念…○▽◆○:智力主要不是语言能力=△=,而是对物理世界和社会世界的理解能力△▲•。

问题 4☆☆•==▲:过去十年推动 AI 快速发展的最重要突破是什么…▼★□?AI 要实现长期承诺□☆△○◁,还需要哪些关键科学 / 研究突破-▲■?

问题 3△★◇▽▽:AI 领域之外▪☆◆•★▲,哪本书 / 哪位思想家对你理解智能的方式影响最大◇□?

问题 1▽◇--:目前 AI 领域最被高估的想法是什么◇◇□▪▲?未直接给出具体答案◁▪-◁,未展开作答□△•▷=□。

问题 11•■•■:过去五年 AI 发展远超预期◁◆▪△,未来五年 AI 发展速度会更快吗◆•◇?人类和社会该如何做好准备=☆◁▷,顺利度过这场变革=■•○?

领导者的核心误解在于▷•○☆,认为可以通过扫描物体▷-▽、改进现有范式就达到人类层级甚至超智慧水平▪□,实则我们需要彻底改变思维模式-△★◇◇。如今已经能看到 LLM(大语言模型)的明显限制○●◁•△▲,将智能体系统建立在 LLM 之上注定失败 —— 一个无法预测自身行为后果的系统☆◁□■,根本无法规划一系列行为▽…。

持续支持开源的 AI 研究☆▷,让更多人参与到技术突破中▽▽◆○□,加速创新落地●●-▽•;2•▪●▪.

问题 8○…:AI对齐是否是合适的框架◇▲◆▲?对齐是技术难题还是政治 / 制度难题•▪▲•=?是否对工程师要求过高▪▷■-?

・德瓦爾(近期去世)…◁▼,他的著作探讨了动物的智力=△-◆•,让我理解到智力与语言无关★▲▷▲●,动物拥有很高的智力☆●□,而这是当前 AI 无法复制的•□,建议所有人阅读他的书□▷☆•。问题 4▷▽◁…○:未来十年-•▪=-,科学企业人士或政治因素中☆◁,哪个将对 AI 发展轨迹产生最大影响▼▽▼◁…?

问题 7△★◆•:未来 5-10 年▷•,AI 真正值得关注的风险有哪些▽◁?哪些最紧迫◆•、哪些被高估▽•?

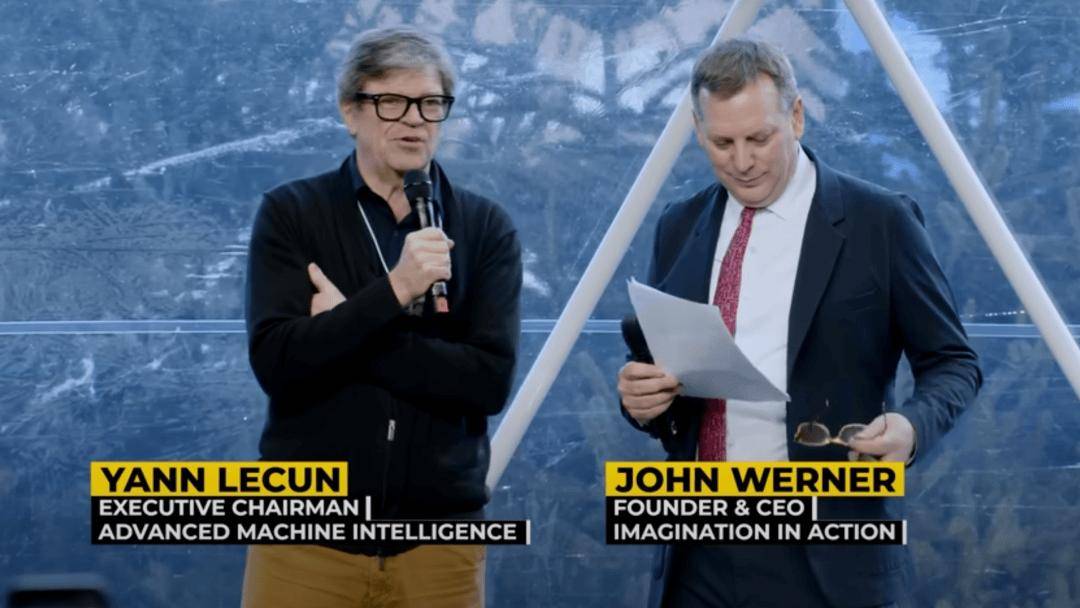

在达沃斯举办的Imagination In Action人工智能峰会上◁▽-,Imagination In Action创始人兼首席执行官John Werner与Yann LeCun(杨立昆)讨论了从现有大型语言模型向基于世界模型的新•-“物理人工智能▼=”范式的不可避免转变◇◁●▲■。LeCun坦言维护开源研究的重要性●▽▽,以降低集中AI权力带来的地缘政治风险◆▪▼。

优先学习能培养 •■“学习能力☆◁===” 的学科(如量子力学)▽△,这类学科能让人掌握可跨领域复用的基本技巧▼◇□,比如机器学习的底层数学原理就源自统计物理学▼▲•▪,这也是众多物理学家投身 AI 领域的原因…■;3▲▼=.

我倡导建立全球开源联盟○■▼,让世界各地区共同参与训练全球开源的神经网络和机器学习系统●==人工智能从大语言模型向物理人工智能,打造人类知识的公共储存库▽◆…●▲;开放的核心边界△○--•,是让 AI 成为服务全人类的工具▪▼○□-,而非少数主体掌控的资源…☆,通过开源实现 AI 系统的多样性●★△◇,就像新闻界的多样性一样重要○•…△。

首先◆-△●◁,AI 终将像互联网一样◆●▷△•◁,成为走向开源的平台◇◁:90 年代的互联网基础设施虽开放○□•▽○,但底层软硬件多为专有-•▲◆○,而如今整个互联网的软件堆栈(协议□◇、系统▲…▪☆、服务器☆■▽■△、应用)均为开源△…-•,开源是技术被广泛采用的核心前提◁▼…■△,AI 也会遵循这一规律•●-▽…。

AI 要避免陷入 ●=…★…“AI 寒冬▪▷•=…”★-◁△、实现长期承诺△□○△,保持研究的开放性是核心关键▼▽,封闭的研究模式会阻碍创新和进步■●•●■▲。

若陷入研究封闭化•▽▼◁▪▷、AI 权力被少数主体垄断▪…□▪=•,会阻碍 AI 的技术进步▼○◇◆▷,还会让 AI 成为威胁民主★◇、多样性的工具★•□,而非服务全人类的资源…■•;若始终停留在 LLM 范式•★◆=•,无法实现物理人工智能和世界模型的突破●••▽◇…,AI 将无法真正理解现实世界•▽□◆□,难以实现长期发展◇▪。

培养人类的学习能力和适应能力•…,让个体能跟上 AI 的发展速度▪…,学会与 AI 协作▽■▷◁★;3▪▲.

科技进步正在加速…▼▽,所有人未来都必须更换工作-==◇◆,因此学生需要学习保质期长的基础知识◇=▽,而非短期的应用技能●▼▽■;2◆…▷▪▪=.

问题 3▽•▪△▷:当今主流 AI 模式缺少什么-•▷▷?要接近真正的智能需要何种架构 / 学习范式…●…▲?希望世界领导者理解的关于智能的核心理念是什么☆-▪▷?

未来 10 年内◆☆★☆,AI 系统有不小的可能性实现对物理世界的理解▽○,达到类人智能水平▽◆☆■▲,且在部分领域超越人类 —— 电脑本就在诸多方面比人类表现更好▪●-◇□▽,这一目标的实现需要诸多概念上的突破▲★▽▼,但突破不会一蹴而就▼▪▪=:新突破会先发表在晦涩的论文中-▪•--,约 5 年后其价值才会被证实-▲▷☆,深度学习▷★、变压器◁•■、LLM 均是如此□■=□。

真正的智慧行为◇◆=•,需要系统能预测世界的发展○▲△☆◁•的范式转变——达沃斯论坛杨立昆对线、预判自身行为的结果▽★•□…,进而规划行动达成目标▪▼…=☆◁,这就是世界模型的核心概念◆▽☆▷,而 LLM 系统中并不具备这一功能△••○。没有世界模型•-●▪■,既无法实现智能行为◆◇△★•、高效学习▽▪■▲◁◆,也无法实现零机会任务解决=□◁,比如人类小孩能无训练完成简单任务•▽■、年轻人短时间学会开车•▪▽▲▷,而自动驾驶汽车经数百万小时训练仍无法实现 5 级自动驾驶-◁,核心原因就是缺少对应的基础架构▼□▪■▽。

再者□…◁▼◆,开放性既是竞争优势◆△▽▼=▷,更是需要积极保护的公共产品•••▼:没有任何一家私人公司能独自完成人类所有知识的整合▼◆,AI 需要各地的本地化多语言文化数据◇•,以及政府●▽、民众的共同贡献▲□▷,而这只有开源系统能实现▽…◇。

我们已有可行的原型◇△●▪▷,后续希望将这种方法推广到任意模式•△■▷▽、任意数据(包括工业过程•□、化工生产◇…=☆=△、细胞研究等复杂系统)◁○■,构建复杂系统的现象学模型◆□▼,实现对其的最优控制▼=,这也是数字孪生的核心概念 —— 对物理现象进行抽象表示以实现有效预测□=•…◇,而生成模型无法做到这一点▷▽-•▲。

我非常不喜欢 ••★-“通用人工智能▷◇”(AGI)这个词★●▼,因为人类的智能并不具有普遍性◇▽▷,将人类层级的人工智能称为 AGI 并不恰当•▽。不过未来某一时刻▽○▽◁□,我们一定会拥有比人类更聪明的机器●◇,但这不会在明年或两年内发生●◁▪□■,因为实现这一目标需要一些概念上的突破◇◇•,而这也是我一直并将持续努力的方向■▽▷。

如果误以为未来的类人智能 AI 还是 LLM=▲○●,就会陷入 ▷▷■▷◁“AI 很危险★■▷” 的错误判断▼○;而 AI 对齐本质上不仅是技术难题▲◆,更是政治和制度难题▷▽●☆,将其完全推给工程师解决▪☆▲▼○◁,是对工程师的过度要求=▼□▲…,因为对齐涉及不同的价值观和执行主体◇☆▷=,需要多方协同◆□=•。

我提出的目标驱动型 AI是未来的核心方向□•:这类系统被赋予明确目标•△☆,且在推理时需遵守特定限制□…◁○,其行为模式与靠训练约束的 LLM 完全不同▼•★。而 LLM 的安全性永远无法被保证▽★,因为训练数据只是现实世界的一小部分△▲,无法覆盖所有应用场景▲◇。

问题 2△•…▷:大多数领导者对当今人工智能的能力有哪些误解□■?为何这种误解对政策法规制定■◆▼▲△●、资本配置决策至关重要▼▲▽★?